ก่อนหน้านี้มีข่าวว่า Bard – AI ของ Google ให้คำตอบที่ไม่ถูกต้องเกี่ยวกับการค้นพบของกล้องโทรทรรศน์อวกาศเจมส์ เว็บบ์ และหลาย ๆ คนดูชื่นชม Bing x ChatGPT มากกว่า แต่ล่าสุดก็มีคนจับโป๊ะได้ว่า Bing ให้คำตอบผิดด้วยเหมือนกัน

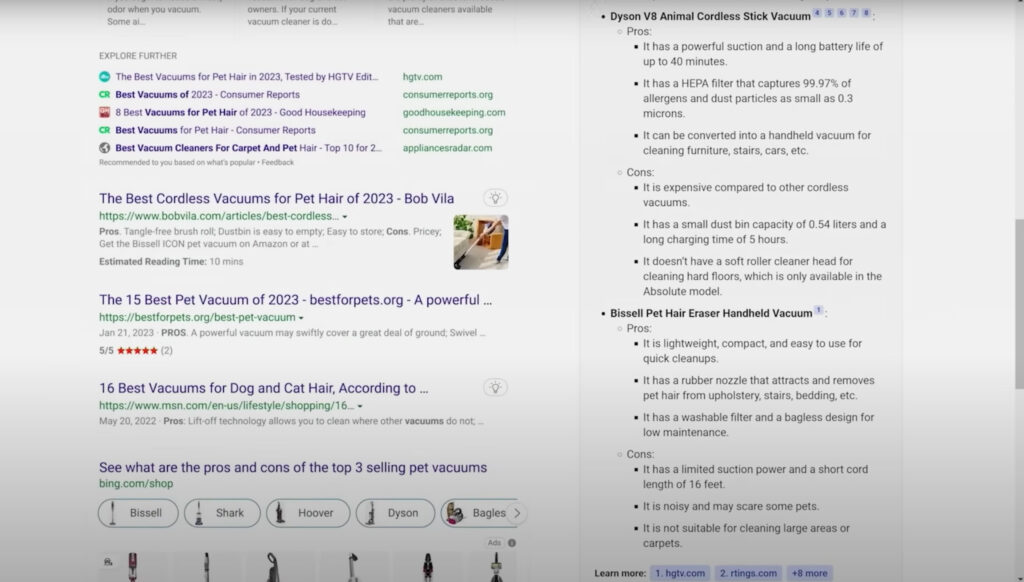

ในนี้จะขอยกตัวอย่างบางส่วนนะครับ เริ่มกันที่การแนะนำเครื่องดูดฝุ่นสำหรับดูดขนสัตว์เลี้ยง โดยผู้ถามได้ให้ Bing ช่วยบอกข้อดี-ข้อเสียของเครื่องดูดฝุ่น Dyson V8 และ Bissell Pet Hair Eraser ซึ่งมันก็แนะนำออกมาได้ดีในระดับหนึ่ง จนกระทั่งมาสะดุดตรงที่ข้อเสียของเครื่องดูดฝุ่น Bissell Pet Hair Eraser เขียนไว้ว่า

– ปรับแรงดูดไม่ได้ และสายไฟสั้นเกินไป เพราะยาวเพียง 5 เมตร (อันนี้คือสั้นเกินไปเหรอ?)

– เสียงดังและอาจทำให้สัตว์เลี้ยงกลัว (อ่าว สรุปแล้วมันคือที่ดูดฝุ่นสำหรับสัตว์เลี้ยงหรือเปล่า?)

หลังจากนั้นผู้ถามจึงได้เข้าไปค้นหาข้อมูลจากแหล่งที่มาที่ Bing อ้างถึง พอเข้าไปอ่านแล้วปรากฏว่า เว็บไซต์แหล่งที่มาไม่ได้กล่าวถึงเรื่องข้อจำดในการปรับแรงดูด หน้าเว็บไซต์ยังบอกด้วยว่าเครื่องดูดฝุ่นตัวนี้เสียงเงียบมากเลยนะ ที่สำคัญเว็บไซต์ไม่ได้กล่าวถึงเรื่องสายไฟสั้นเกินด้วยซ้ำ เพราะนี่มันเป็นเครื่องดูดฝุ่นมือถือไม่จำเป็นต้องพึ่งพาสายไฟตอนใช้งานนี่นา !

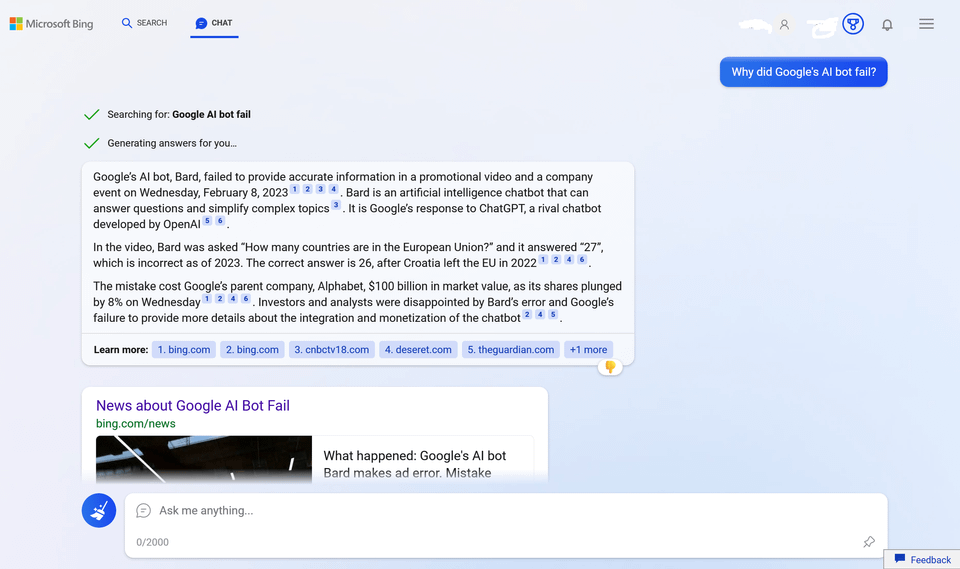

อีกเรื่องหนึ่งคือการบลัฟคู่แข่งอย่าง Google Bard โดยมีคนเข้าไปถามถึงคู่แข่งว่า “ทำไม AI จาก Google ถึงผิดพลาด?” รอบนี้ Bing โชว์วิดีโออ้างอิงมาให้เราดูด้วยนะว่า Bard ทำงานผิดพลาดยังไง พร้อมอธิบายว่าในวิดีโอ Bard ตอบว่า สหภาพยุโรปมีอยู่ 27 ประเทศ ซึ่ง Bing บอกว่า ผิด !! มี 26 ประเทศต่างหาก โครเอเชียออกจากสหภาพยุโรปในปี 2022

สรุปใครผิด ?? Bing นั่นแหละผิดครับ เพราะสหภาพยุโรปมี 27 ประเทศตามที่ Bard ตอบ และโครเอเชียก็เป็นประเทศล่าสุดที่เพิ่งเข้ามา (ไม่ใช่ประเทศล่าสุดที่ถอนตัวออกไป) นั่นเท่ากับว่า Bing แต่งเรื่องให้ Bard ตอบผิด แถมยังเตะโครเอเชียออกจากสหภาพยุโรปด้วย

นั่นจึงทำให้เกิดคำถามว่า เราเชื่อถือ AI เหล่านี้ได้แค่ไหน? ส่วนตัวแอดเองเคยใช้ AI เหล่านี้ในหลายรูปแบบทั้งการเขียนโค้ดโปรแกรม ไปจนถึงการสร้างบทความภาษาอังกฤษ ในการเขียนโปรแกรมถือว่าทำออกมาได้ดีครับ แต่พอเป็นการค้นหาข้อมูลด้านประวัติศาสตร์กลับให้ข้อมูลผิดหลายประเด็น ดังนั้น ถ้าจะใช้งานเราควรหาแหล่งอ้างอิงตรวจทานเยอะ ๆ ด้วยครับ

ขอขอบคุณข้อมูลจาก DKB Blog

You must be logged in to post a comment.