อินเทลเร่งพัฒนา AI ทั้งการใช้งานและประสิทธิภาพด้วยฮาร์ดแวร์ปัญญาประดิษฐ์รุ่นใหม่ที่เปลี่ยนจากคลาวด์สู่ Edge

What’s new: วันนี้ ในงานประชุมและสัมมนาครั้งใหญ่ด้านปัญญาประดิษฐ์ อินเทลประกาศเปิดตัวคลื่นลูกใหม่ของเทคโนโลยีที่กำลังมาแรงนี้ ด้วยผลิตภัณฑ์ที่ออกแบบมาเพื่อเร่งการพัฒนาระบบปัญญาประดิษฐ์โดยเฉพาะ พร้อมรองรับแนวโน้มปรับการใช้งานจากคลาวด์สู่ชายขอบ (Edge) โดยอินเทลได้สาธิตการใช้งานระบบประมวลผล Intel® Nervana™ Neural Network Processors (NNP) สำหรับการเทรนปัญญาประดิษฐ์ (NNP-T1000) และการประมวลผล (NNP-I1000) ด้วยการอนุมานจากชุดข้อมูลที่ปัญญาประดิษฐ์นั้นได้รับการเทรนมา ซึ่งเป็นวงจรรวมใช้งานเฉพาะทาง (Application-Specific Integrated Circuit: ASICs) ชุดแรกๆ ที่อินเทลพัฒนาขึ้นเพื่อการเรียนรู้เชิงลึกที่มีความซับซ้อน ด้วยความสามารถด้านการปรับเปลี่ยนขนาดการใช้งานและประสิทธิภาพ เหมาะสำหรับลูกค้าผู้ให้บริการคลาวด์และดาต้าเซนเตอร์ นอกจากนี้ อินเทลยังเผยโฉมหน่วยประมวลผล Intel® Movidius™ Vision Processing Unit (VPU) รุ่นใหม่สำหรับสื่อชายขอบ (Edge Media) ภาพที่ประมวลผลด้วยคอมพิวเตอร์ (Computer Vision) ตลอดจนแอพพลิเคชั่นที่ประมวลผลด้วยการอนุมาน (Inference Applications) อีกด้วย

“เทคโนโลยีปัญญาประดิษฐ์ก้าวหน้ามาถึงจุดที่เปลี่ยนผ่านในเชิงความสามารถในการประมวลผลของฮาร์ดแวร์และหน่วยความจำ ฮาร์ดแวร์เฉพาะทางอย่าง Intel® Nervana NNP และ Movidius Myriad VPUs นี้จำเป็นต่อการพัฒนาปัญญาประดิษฐ์ต่อไปในอนาคต การใช้ปัญญาประดิษฐ์ระดับระบบในรูปแบบขั้นสูงนี้ช่วยให้เราข้ามผ่านจากการเปลี่ยนข้อมูลดิบเป็นข้อมูลสารสนเทศที่มีความหมาย ไปสู่การเปลี่ยนข้อมูลสารสนเทศที่มีความหมายเป็น องค์ความรู้” – นาวีน ราโอ รองประธานบริษัทและผู้จัดการทั่วไปกลุ่มผลิตภัณฑ์ปัญญาประดิษฐ์ของอินเทล

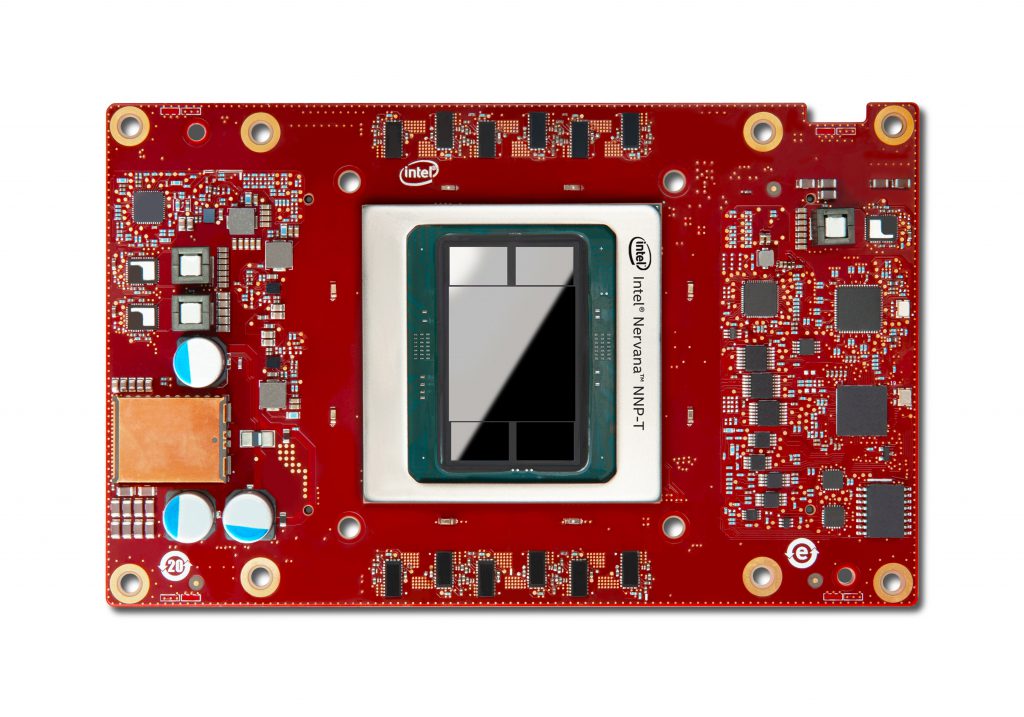

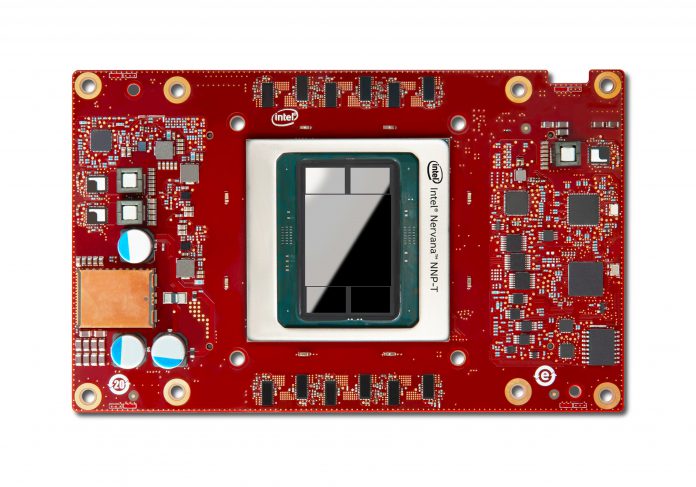

รูปภาพแสดง Intel Nervana NNP-T สำหรับการเทรนนิ่งบนการ์ด Mezzanine โปรเซสเซอร์ Intel Nervana Neural Network เป็นวงจรรวมใช้งานเฉพาะทาง (Application-Specific Integrated Circuit: ASICs) ชุดแรกๆ ที่อินเทลพัฒนาขึ้นเพื่อการเรียนรู้เชิงลึกที่มีความซับซ้อน ด้วยความสามารถด้านการปรับเปลี่ยนขนาดการใช้งานและประสิทธิภาพ เหมาะสำหรับลูกค้าผู้ให้บริการคลาวด์และดาต้าเซนเตอร์ อินเทลได้สาธิตการใช้งานระบบประมวลผล Intel® Nervana™ Neural Network Processors (NNP) ณ งาน AI Summit ในวันที่ 12 พฤศจิกายน 2562 ที่ ซานฟรานซิสโก (เครดิต: อินเทล คอร์ปอเรชั่น)

Why They Are Important: ผลิตภัณฑ์เหล่านี้ช่วยเสริมความแข็งแกร่งของอินเทลด้านโซลูชั่นส์ปัญญาประดิษฐ์ ที่คาดว่าจะสร้างรายได้มากกว่า 3.5 พันล้านดอลลาร์สหรัฐฯ ภายในปี 2562 นี้ โซลูชั่นส์ด้านปัญญาประดิษฐ์ของอินเทลซึ่งครบครันที่สุดทั้งทางกว้างและทางลึกในอุตสาหกรรมนี้ ช่วยให้ลูกค้าสามารถพัฒนาและนำโมเดลปัญญาประดิษฐ์ไปใช้งานในทุกระดับตั้งแต่คลาวด์ขนาดใหญ่ไปจนถึงอุปกรณ์ชายขอบขนาดจิ๋ว รวมไปถึงอุปกรณ์อื่นๆ

What Intel Announced: ขณะนี้ โปรเซสเซอร์ Intel Nervana NNPs รุ่นใหม่อยู่ระหว่างการผลิตและจัดส่งให้แก่ลูกค้า โดยโปรเซสเซอร์รุ่นนี้เป็นส่วนหนึ่งของการพัฒนาปัญญาประดิษฐ์ระดับระบบ ที่มาพร้อมซอฟต์แวร์ชนิดเต็มรูปแบบซึ่งพัฒนาขึ้นด้วยองค์ประกอบแบบเปิดและการบูรณาการกรอบการเรียนรู้เชิงลึกเพื่อการใช้งานสูงสุด

โปรเซสเซอร์ Intel Nervana NNP-T ตอบโจทย์ความสมดุลระหว่างการคำนวน การสื่อสาร และหน่วยความจำ จึงรองรับการขยายขนาดอย่างมีประสิทธิภาพในแง่พลังงาน จากคลัสเตอร์ขนาดเล็กไปเป็นซุปเปอร์คอมพิวเตอร์ขนาดใหญ่ ในแบบที่เกือบเป็นเส้นตรง โปรเซสเซอร์ Intel Nervana NNP-I ประหยัดทั้งพลังงานและงบประมาณ จึงเหมาะกับการใช้งานที่ต้องมีการอนุมานแบบหลายโหมดในสเกลใหญ่โดยใช้ปัจจัยที่ยืดหยุ่น ผลิตภัณฑ์ทั้งสองตัวนี้ได้รับการพัฒนาขึ้นเพื่อตอบสนองความต้องการประมวลผลด้านปัญญาประดิษฐ์ เพื่อลูกค้าที่ใช้ปัญญาประดิษฐ์ชายขอบ อาทิ Baidu และ Facebook

“เรารู้สึกตื่นเต้นมากที่ได้ร่วมงานกับอินเทลในการใช้งานโปรเซสเซอร์ Intel Nervana Neural Network Processor ที่ช่วยให้การประมวลผลเชิงอนุมานที่รวดเร็วและมีประสิทธิภาพมากขึ้น สำหรับการอนุมานและเพิ่มการสนับสนุนให้แก่ Glow ซึ่งเป็นคอมไพเลอร์สำหรับการเรียนรู้เชิงลึกอันทันสมัยของเรา ตลอดจนโปรเซสเซอร์ NNP-I” มิชา

สมีเลียนสกี ผู้อำนวยการระบบปัญญาประดิษฐ์ (AI) และการออกแบบร่วมของเฟซบุ๊ค

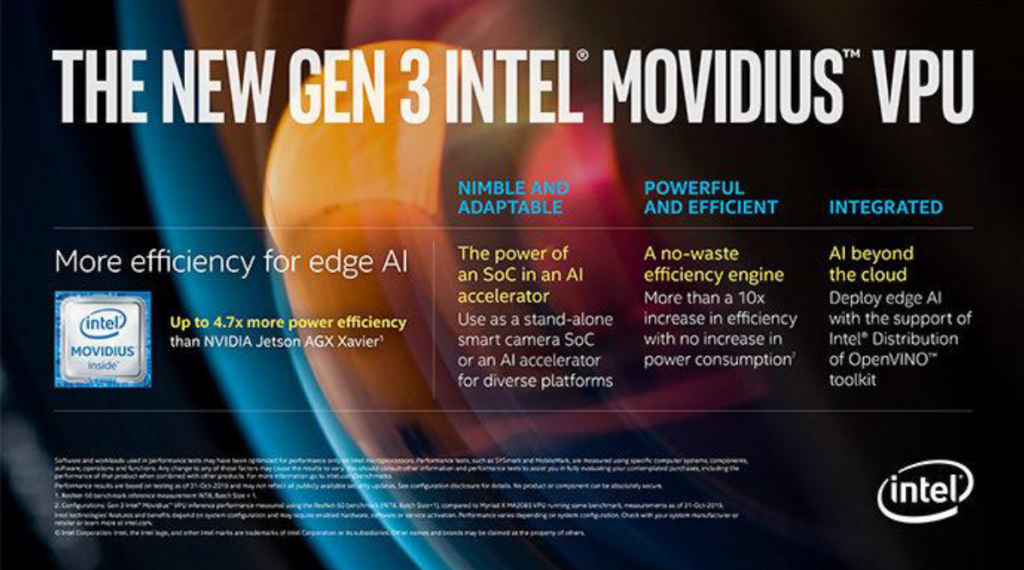

ยิ่งไปกว่านั้น โปรเซสเซอร์ Intel Movidius VPU รุ่นใหม่ซึ่งมีกำหนดการวางจำหน่ายภายในครึ่งปีแรกของปี 2563 ยังรวมเอาความก้าวหน้าด้านการออกแบบที่มีเอกลักษณ์เฉพาะตัวและทรงพลัง เพื่อประสิทธิภาพการประมวลผลเชิงอนุมานที่สูงกว่าโปรเซสเซอร์รุ่นก่อนหน้าถึงกว่า 10 เท่า อีกทั้งยังประหยัดพลังงานสูงสุดถึง 6 เท่าเมื่อเปรียบเทียบกับโปรเซสเซอร์คู่แข่ง นอกจากนี้ อินเทลยังประกาศเปิดตัว Intel® DevCloud ใหม่สำหรับ Edge ซึ่งเมื่อใช้งานร่วมกับชุดเครื่องมือ Intel® Distribution of OpenVINO™ แล้ว สามารถจัดการกับหนึ่งในปัญหาสำคัญที่นักพัฒนากำลังเผชิญอยู่ คือช่วยให้สามารถทดลอง พัฒนาต้นแบบ และทดสอบโซลูชั่นปัญญาประดิษฐ์กับโปรเซสเซอร์ของอินเทลได้หลากหลายก่อนตัดสินใจซื้อฮาร์ดแวร์

Why It Matters: ข้อมูล โมเดล และเทคนิคที่ซับซ้อนอย่างยิ่ง จำเป็นต่อการพัฒนาหลักการให้เหตุผลและบริบทของการเรียนรู้เชิงลึก และนำมาซึ่งการออกแบบสถาปัตยกรรมให้ต่างออกไป เนื่องจากผู้ใช้ส่วนใหญ่มีการใช้งานปัญญาประดิษฐ์บางส่วนบนโปรเซสเซอร์ Intel® Xeon®™ Scalable อยู่แล้ว อินเทลจึงเดินหน้าปรับปรุงแพลตฟอร์มนี้ด้วยฟีเจอร์ต่างๆ อาทิ การปรับปรุง Intel® Deep Learning Boost ด้วย Vector Neural Network Instruction (VNNI) ซึ่งช่วยยกระดับประสิทธิภาพการประมวลผลเชิงอนุมานด้วยระบบปัญญาประดิษฐ์ผ่านดาต้าเซ็นเตอร์และ Edge แม้ว่านี่จะยังเป็นรากฐานอันแข็งแกร่งของเทคโนโลยีปัญญาประดิษฐ์ไปอีกหลายปี แต่ความต้องการเทรนการเรียนรู้เชิงลึกของลูกค้าอินเทลนั้นคือเพิ่มประสิทธิภาพเป็นสองเท่าทุกๆ สามเดือนครึ่ง ซึ่งทำได้ด้วยโซลูชั่นปัญญาประดิษฐ์ของอินเทลเท่านั้น ทั้งนี้ อินเทลพร้อมเติมเต็มภาพรวมของการคำนวณ หน่วยความจำ อุปกรณ์จัดเก็บข้อมูล การเชื่อมต่อระหว่างกัน ตลอดจนซอฟต์แวร์ เพื่อประสิทธิภาพและความสามารถทางโปรแกรมสูงสุด จนมั่นใจได้ว่าสามารถรองรับการเรียนรู้เชิงลึกผ่านอุปกรณ์หลายพันเครื่อง อันจะนำไปสู่การปฏิวัติองค์ความรู้นั่นเอง

เนื้อหาเพิ่มเติม: 2019 AI Summit (Press Kit) | Artificial Intelligence at Intel (press kit) | At Hot Chips, Intel Pushes ‘AI Everywhere’

You must be logged in to post a comment.