มาทำความรู้จักกับเจ้า NVIDIA Pascal GP100 ก่อนวางขายจริง

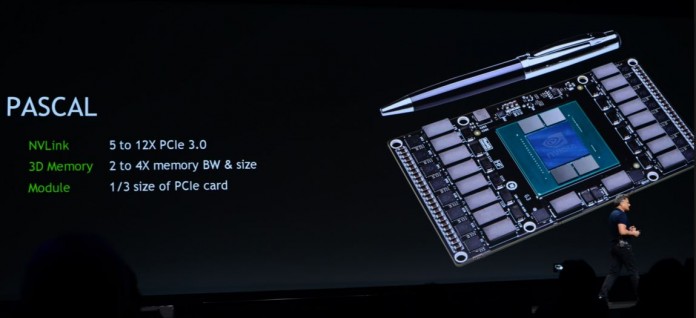

“Pascal” GPU architecture ที่กำลังจะออกมาของทาง NVIDIA เรียกได้ว่าเป็นปีศาจทางด้านความละเอียดของภาพเลยก็ว่าได้ เพราะการเปิดตัวของ Tesla P100 ที่งาน GTC 2016, ได้เปิดเผยรายละเอียดและ block diagram ของ “GP100” silicon ที่มาทำหน้าที่ของมัน เริ่มแรกเลยก็คือตัว GP100 เป็นแบบ multi-chip module ที่เหมือนกับทาง AMD’s “Fiji,” ที่มีขนาด GPU die ที่ใหญ่,มี memory-stacks ถึง 4 ตัว, และ silicon wafer/ตัวประสานระหว่างกัน (interposer) ทำหน้าที่เป็นตัวเชื่อม/substrate ระหว่างGPU และ memory stacks, ซึ่งทาง NVIDIA สามารถเดินสายไฟได้ขนาดที่เล็กมาก/microscopic ระหว่างกัน ตัว GP100 จะประกอบไปด้วย 4096-bit wide HBM2 memory interface, และมี memory bandwidths เร็วได้ถึง 1 TB/s. โดยในตัว P100, ในส่วนของ memory ทำความเร็วได้ในย่านความถี่ที่ 720 GB/s.

ตัว GP100 นั้นการออกแบบก็จะเหมือน NVIDIA GPUs ทั่วไป, โดยเฉพาะตัวสำคัญที่เป็น bus และ memory ที่จะ interfaces/ประสาน. ตัว PCI-Express gen 3.0 x16 เป็นตัวหลักที่ประสาน/interface ที่จะต่อเข้ากับ GPU ในเครื่องคอม ตัว GigaThread Engine จะกระจายหน้าที่ไปยัง graphics processing clusters (GPCs) ทั้ง 6 ตัว. มี memory controllers ถึง 8 ตัว รวมกันแล้วก็เท่ากับ 4096-bit wide HBM2 memory interface, และมี “High-speed Hub” รุ่นใหม่ ที่ต่อออกไปยัง NVLink ports ทั้ง 4 ช่อง. แต่ในตอนนี้ยังไม่เป็นที่รู้อย่างแน่นอนว่าจะมีความเร็วที่ 80 GB/s (per-direction/ทางเดียวกัน) ต่อช่อง หรือทั้งหมดรวมกันได้ 80 GB/s (per-direction)

GP100 จะประกอบไปด้วย graphics processing clusters (GPCs) 6 ตัว. ซึ่งเป็นอิสระซึ่งกันและกันในส่วนของ GPU, ที่สามารถจ่ายภาพหรือให้ในส่วนด้านหน้าและส่วนด้านท้าย ด้วยโครงสร้างฐานที่เป็น”Pascal” architecture, และการทำงานบนตัว GP100, แตละตัวของ GPC จะประกอบไปด้วย streaming multiprocessors (SMs) ถึง 10 ตัว, ซึ่งเป็นจำนวนตัวเลขพื้นฐานของ GPU. แต่ละตัวของ SM จะมี 64 CUDA cores. เพราะฉนั้นตัว GPC ก็จะมีจำนวนทั้งหมดเป็น 640 CUDA cores, และใน GP100 chip ก็จะมีทั้งหมด 3,840 CUDA cores. ส่วนรายละเอียดทางด้านอื่นที่จำเป็นก็จะมี 240 TMUs/ตัวประมวลผลของชุดคำสั่ง. มาดูตัว Tesla P100 กันบ้าง, NVIDIA สามารถที่จะเปิดใช้งานได้แค่ 56 จากจำนวนของ 60 streaming multiprocessors, จำนวนทั้งหมดก็จะเป็น 3584 ที่เป็น CUDA core count

ดูเหมือน “Pascal” architecture จะมีประสิทธิภาพทางด้าน clock speeds ค่อนข้างสูง . ส่วนตัว Tesla P100, จะมีขีดความสามารถทางด้าน core clock speed ได้ที่ 1328 MHz, และ GPU Boost ได้ที่ 1480 MHz, และ TDP ที่ 300W. ด้วยพลังงานการใช้ขนาดนี้อาจจะทำให้ดูแล้วน่ากลัว แต่อย่าลืมว่าตัว memory stacks ได้ย้ายไปอยู่รวมกับ GPU package, และมีตัว heatsink ระบายให้อยู่ ทั้งตัว GPU die, memory stacks, และ ส่วนอื่นๆอีกที่จะทำให้เกิดความร้อนบน multi-chip module.

ตัว NVLink. เป็นการพัฒนาและคิดค้นจากทาง NVIDIA ซึ่งทำหน้าที่และการติดตั้ง multi-GPU คล้ายกับ multi-socket CPU รุ่นใหม่ๆ, ไม่ว่าจะเป็น QPI (Intel) หรือ HyperTransport (AMD) ซึ่งการต่อเชื่อมจะเหมือนกับว่ามีทางด่วนต่อเชื่อมกันระหว่าง sockets. ในแต่ละ NVLink path/ช่องทางสามารถมี bandwidth ได้ถึงขนาด 80 GB/s (per direction), ซึ่งสามารถถ่ายโอนได้โดยตรงจาก memory virtualization/หน่วยความจำแบบเสมือน ไปยังระหว่างตัว multiple GPUs. ด้วยวิธีนี้ก็เป็นข้อพิสูจน์แล้วว่าตัว GPU-accelerated HPC systems มีประโยชน์จริง, โดยตัว GPU ตัวหนึ่งจะสามารถเข้าถึง memory controlled ได้จาก GPU อีกตัวหนึ่ง, และตัว software ก็จะเห็นได้รับรู้จำนวน GPUs’ memory ทั้งสองตัวที่เพิ่มขึ้นเป็นเพียงตัวเดียวกันและเป็นบล็อคๆติดๆกัน Pascal Unified Memory system/การจัดรวมกัน ยังยอมให้ ยกตัวอย่าง GPU programming models ที่มีความก้าวหน้ามากอย่างตัว CUDA 8 สามารถที่สะสม memory ได้มากกว่าความเป็นจริงในส่วนของ GPU physically controls/ด้านความเป็นจริง, และรวมถึงตัว system memory ด้วย

ที่มาเครดิต techpowerup

You must be logged in to post a comment.